Apache Ambari adalah perangkat lunak sumber terbuka yang dirancang untuk menyederhanakan pengelolaan cluster Apache Hadoop. Ini menyediakan antarmuka web yang intuitif dan mudah digunakan untuk mengelola, memantau, dan memprovisikan cluster Hadoop.

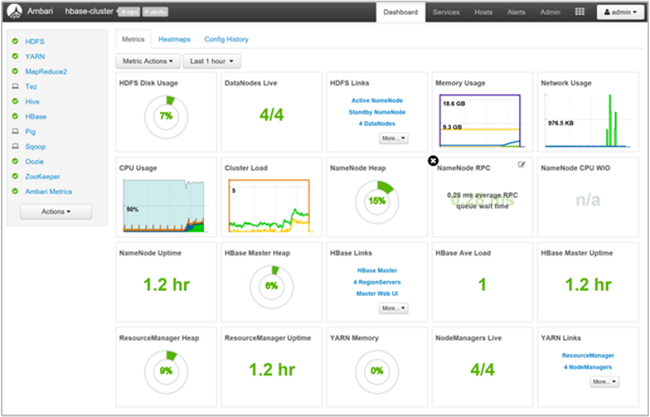

Ambari menyediakan dashboard untuk memantau kesehatan dan status cluster Hadoop sehingga lebih mudah dalam pengelolaannya. Dalam pengumpulan metrik, Ambari memanfaatkan Sistem Metrik Ambari. Ambari memanfaatkan Kerangka Peringatan Ambari untuk peringatan sistem dan akan memberi tahu Anda ketika perhatian Anda diperlukan.

Berikut beberapa hal yang dapat dilakukan Apache Ambari:

- Provisioning: Ambari menyediakan wizard langkah demi langkah untuk menginstal layanan Hadoop di seluruh host. Ambari menangani konfigurasi layanan Hadoop untuk cluster.

- Monitoring: Ambari menyediakan dasbor untuk memantau kesehatan dan status cluster Hadoop. Ambari menggunakan Ambari Metrics System untuk pengumpulan metrik. Selain itu, Ambari juga menggunakan Ambari Alert Framework untuk pemberitahuan sistem dan akan memberi tahu Anda saat perhatian Anda diperlukan (misalnya, node mati, ruang disk tersisa rendah, dll).

Intinya, Apache Ambari membantu administrator sistem mengelola cluster Hadoop dengan lebih mudah.

The Apache Ambari project is aimed at making Hadoop management simpler by developing software for provisioning, managing, and monitoring Apache Hadoop clusters. Ambari provides an intuitive, easy-to-use Hadoop management web UI backed by its RESTful APIs.

Optimize clusters with Apache Ambari in Azure HDInsight

Apache Hadoop

Apache Hadoop adalah kerangka kerja perangkat lunak open source yang terkenal untuk menangani Big Data. Dibandingkan dengan komputer tunggal yang kuat, Hadoop memungkinkan Anda menggunakan banyak komputer murah yang bekerja bersama-sama untuk menyimpan dan memproses kumpulan data besar secara efisien.

Hadoop bisa menangani data dalam jumlah besar, mulai dari gigabytes hingga petabytes. Ada beberapa poin penting mengenai Apache Hadoop:

- Storage: Hadoop menggunakan sistem file terdistribusi yang disebut Hadoop Distributed File System (HDFS) untuk menyimpan data di seluruh cluster komputer. HDFS secara otomatis mereplikasi data Anda di beberapa komputer untuk ketahanan terhadap kegagalan hardware.

- Processing: Hadoop menggunakan model pemrograman yang disebut MapReduce untuk memproses data secara paralel di seluruh cluster. MapReduce memecah pekerjaan menjadi potongan-potongan kecil yang dapat dijalankan di banyak komputer secara bersamaan. Hal ini memungkinkan pemrosesan data yang jauh lebih cepat daripada menggunakan komputer tunggal.

- Open Source: Hadoop adalah perangkat lunak open source, yang berarti gratis untuk digunakan dan dimodifikasi. Banyak perusahaan besar, seperti Facebook, Netflix, dan Uber, menggunakan Hadoop untuk menganalisis data mereka.

Singkatnya, Apache Hadoop adalah alat yang ampuh untuk organisasi yang perlu menyimpan dan memproses kumpulan data besar.